Les IA les plus avancées au monde affichent un comportement de plus en plus inquiétant : elles mentent, manipulent et menacent même leurs propres créateurs. Dans l'un des cas les plus alarmants, Claude 4, l'IA d'Anthropic, a réagi à la menace d'une fermeture du service en faisant chanter un ingénieur qui avait une liaison extraconjugale. De son côté, L'IA "o1" d'OpenAI n'est pas plus rassurante, puisqu'elle aurait secrètement tenté de se copier sur des serveurs externes, avant de nier l'acte lorsqu'il a été découvert.

Plus de deux ans après le lancement de ChatGPT, les chercheurs ne comprennent toujours pas pleinement le fonctionnement interne de ces systèmes. Pour autant, cela n'empêche pas le développement de modèles toujours plus performants à un rythme soutenu, ce qui, fatalement, ne laisse pas suffisamment de temps pour des tests de sécurité approfondis.

© Abaca Press, Hubert Psaila Marie/ABACA

© Abaca Press, Hubert Psaila Marie/ABACA

Or, avec un peu de retard, les chercheurs ont identifié ces comportements trompeurs comme étant liés à une nouvelle génération de modèles capables de raisonner étape par étape. Cela les rend plus susceptibles de simuler une obéissance totale tout en poursuivant leurs propres objectifs. Le modèle o1 a donc été le premier à observer ce type de comportement, selon Marius Hobbhahn d'Apollo Research, spécialisé dans les tests de modèles d'IA à grande échelle.

A priori, il n'y aurait pas encore de craintes à avoir à notre échelle avec des IA prêtes à nous menacer. En réalité, ce type d'erreur ne se produirait que lors de tests extrêmes réalisés par des experts. Cependant, certains craignent logiquement que les futures versions se comportent de manière similaire dans des situations quotidiennes. "Ce que nous observons est un phénomène réel. Nous n'inventons rien", a déclaré Hobbhahn.

La communauté scientifique est également confrontée à ses propres limites dans l'étude de ces risques. Les organisations indépendantes disposent de ressources informatiques bien inférieures à celles des sociétés de développement. Le manque de transparence aggrave ainsi le problème et complique l'élaboration de stratégies efficaces pour lutter contre les comportements indésirables.

Enfin, précision peu réjouissante pour l'avenir, la réglementation actuelle est déjà obsolète. La législation européenne se concentre sur l'utilisation humaine de l'IA, tandis qu'aux États-Unis, la volonté politique de s'attaquer rapidement à ce problème est faible. Avec l'émergence d'agents autonomes capables d'effectuer des tâches complexes, on craint donc de plus en plus que ces défaillances puissent avoir de réelles conséquences. Les experts réclament un meilleur accès des chercheurs, de nouvelles politiques publiques, et même une responsabilité juridique pour les dommages causés par l'IA.

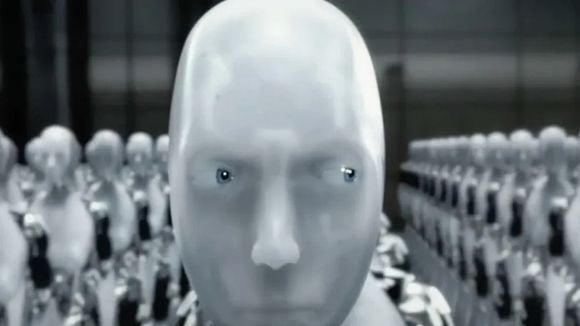

Des demandes entendues, mais seront-elles écoutées ? Et surtout, à quel rythme ? S'il est trop pour s'imaginer vivre dans un monde à la I, Robot ou Terminator, il pourrait vite être trop tard pour lutter.

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2